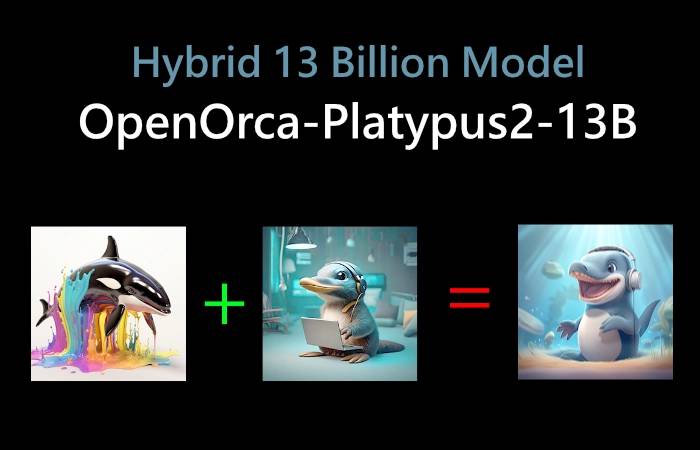

在不断发展的人工智能世界中,出现了一种新的模式,正在行业中掀起波澜。OpenOrca-Platypus2-13B是garage-bAInd/Platypus2-13B和Open-Orca/OpenOrcaxOpenChat-Preview2-13B的融合,已经亮相。这种创新型号不仅仅是其前身的简单组合,而是一个声称优于原始Llama-65B模型的优越实体。

OpenOrca-鸭嘴兽2-13B证明了合作的力量。OrcaPlatypus模型的创建者与鸭嘴兽团队合作开发了一个模型,该模型不仅在排行榜上名列前茅,而且还突破了AI领域可能的界限。

OpenOrca Platypus2 13B型号

语言模型评估工具用于运行基准测试,使用与HuggingFace LLM排行榜相同的版本。结果令人印象深刻。OpenOrca-Platypus2-13B模型在AGI Eval上表现出112%的性能,平均为2.0。这种提升的很大一部分可以归因于LSAT逻辑推理性能的显着提高。查看下面由提示工程YouTube频道制作的视频,以了解有关这种新混合动力模型的更多信息。

OpenOrca-Platypus2-13B模型是基于Llama 2转换器架构的自回归语言模型。它由Cole Hunter和Ariel Lee为鸭嘴兽2-13B和Open-Orca为OpenOrcaxOpenChat-Preview2-13B训练。该模型以英语运行,并获得鸭嘴兽4-0B基本砝码的非商业知识共享许可(CC BY-NC-2.13)和OpenOrcaxOpenChat-Preview2-2B基本砝码的Llama 13商业许可。

Open ARCA Platypus2 13B 型号是 Open ARCA 和Platypus2 型号的混合体,因其出色的性能而备受关注。作者断言,这个13亿个参数模型在特定数据集上可以超过原来的65亿个参数模型Lama 65B。该模型在用于原始鸭嘴兽213B模型的STEM和基于逻辑的数据集以及使用GPT4派生的Open ARCA数据集上进行训练。

该模型擅长逻辑问题以及与科学、技术和工程相关的主题。它可以生成连贯且写得很好的文本,例如给OpenAI首席执行官的一封信,甚至编程代码。但是,用户应注意,模型在基准数据集上的性能可能无法反映其在特定应用程序上的性能,并且训练集和测试集之间可能存在潜在的数据泄漏。

开源大语言模型领域的快速创新对未来的发展既令人兴奋又充满希望。OpenOrca-Platypus2-13B模型是这一创新的光辉典范,为AI模型设定了新标准。