一家机器人初创公司的首席技术官告诉我,“我们认为我们必须做很多工作来构建’机器人ChatGPT’。相反,事实证明,在很多情况下,ChatGPT是机器人的ChatGPT。

直到最近,人工智能模型还是专门的工具。在特定领域(如机器人技术)中使用人工智能意味着花费时间和金钱专门针对该领域创建人工智能模型。例如,谷歌的AlphaFold是一种用于预测蛋白质折叠的AI模型,它是使用蛋白质结构数据训练的,只对处理蛋白质结构有用。

这位创始人认为,要从生成式AI中受益,机器人公司需要为机器人技术创建自己的专用生成AI模型。相反,该团队发现,在许多情况下,他们可以使用现成的ChatGPT来控制他们的机器人,而无需AI专门训练过。

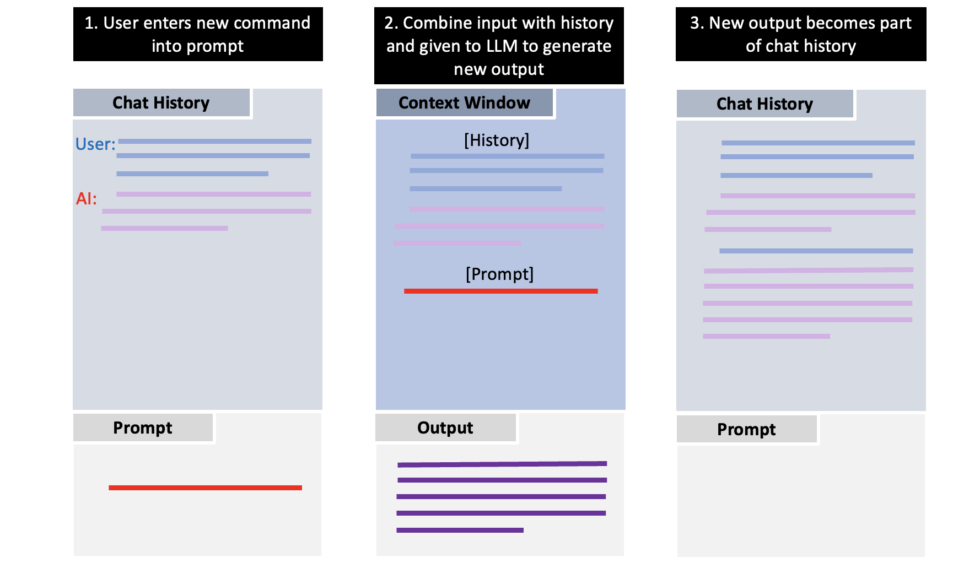

我从从事从健康保险到半导体设计等各个领域的技术人员那里听到了类似的事情。为了创建ChatGPT,一个让人类通过简单地进行对话来使用生成AI的聊天机器人,OpenAI需要改变像GPT3这样的大型语言模型(LLM),以更好地响应人类互动。

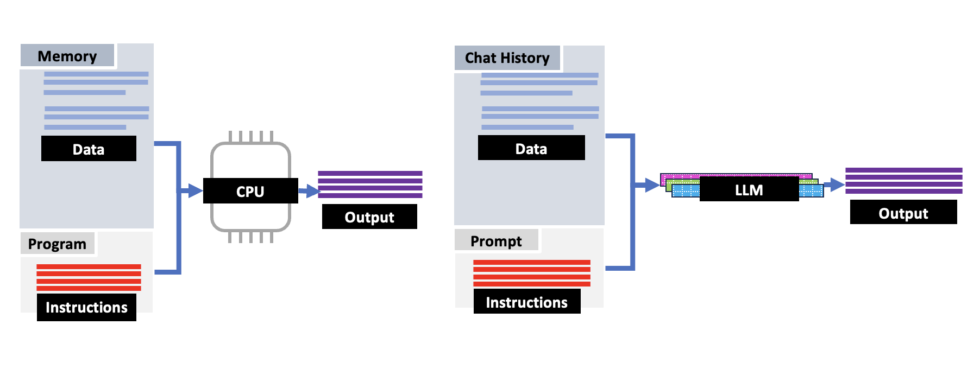

但也许无意中,这些相同的变化让 GPT3 的继任者(如 GPT3.5 和 GPT4)被用作强大的通用信息处理工具——这些工具不依赖于 AI 模型最初训练的知识或模型训练的应用程序。这需要以完全不同的方式使用AI模型 – 编程而不是聊天,新数据而不是训练。但它为人工智能开辟了道路,使其成为通用而非专用,更像是一种“任何工具”。

现在,在人工智能炒作的时代,一个重要的警告是:当我说“通用”和“任何工具”时,我的意思是CPU是通用的,而不是专用的信号处理芯片。它们是可用于各种任务的工具,而不是全能和无所不知的。就像优秀的程序员不会在没有代码审查和单元测试的情况下将代码部署到生产环境中一样,人工智能输出也需要自己的流程和程序。我在下面讨论的应用程序是用于提高人类生产力的工具,而不是横行运行的自主代理。但重要的是认识到人工智能可以做什么。

那么,我们是如何走到这一步的呢?

基础知识:概率、梯度下降和微调

让我们花点时间谈谈为生成式人工智能提供动力的LLM是如何工作的,以及它们是如何训练的。

像 GPT4 这样的 LLM 是概率性的;他们接受输入并预测与该输入相关的单词和短语的概率。然后,它们生成一个最适合给定输入的输出。这就像一个非常复杂的自动完成:拿一些文本,然后告诉我接下来会发生什么。从根本上说,这意味着生成式人工智能不是生活在“对与错”的环境中,而是“越来越不可能”。

概率有优点和缺点。弱点是众所周知的:生成式人工智能可能是不可预测和不准确的,不仅容易产生糟糕的输出,而且会以你意想不到的方式产生它。但这也意味着人工智能可以以传统的、基于规则的系统无法做到的方式变得不可预测的强大和灵活。我们只需要以一种有用的方式塑造这种随机性。

打个比方。在量子力学出现之前,物理学家认为宇宙以可预测的、确定性的方式运作。量子世界的随机性起初令人震惊,但我们学会了接受量子怪异,然后实际使用它。量子隧穿基本上是随机的,但它可以被引导,使粒子以可预测的模式跳跃。这就是导致半导体和芯片为您正在阅读本文的设备供电的原因。不要只接受上帝与宇宙玩骰子——学习如何装骰子。

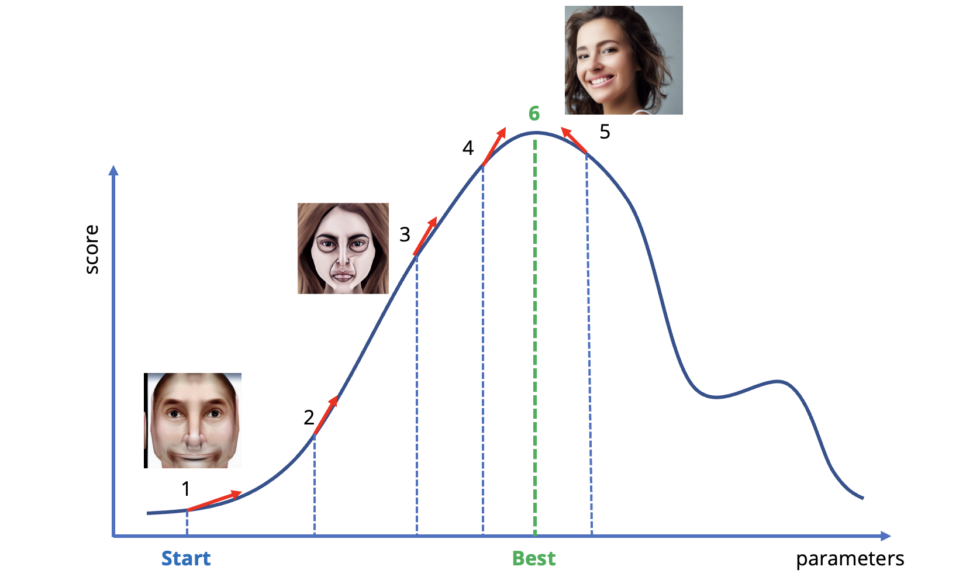

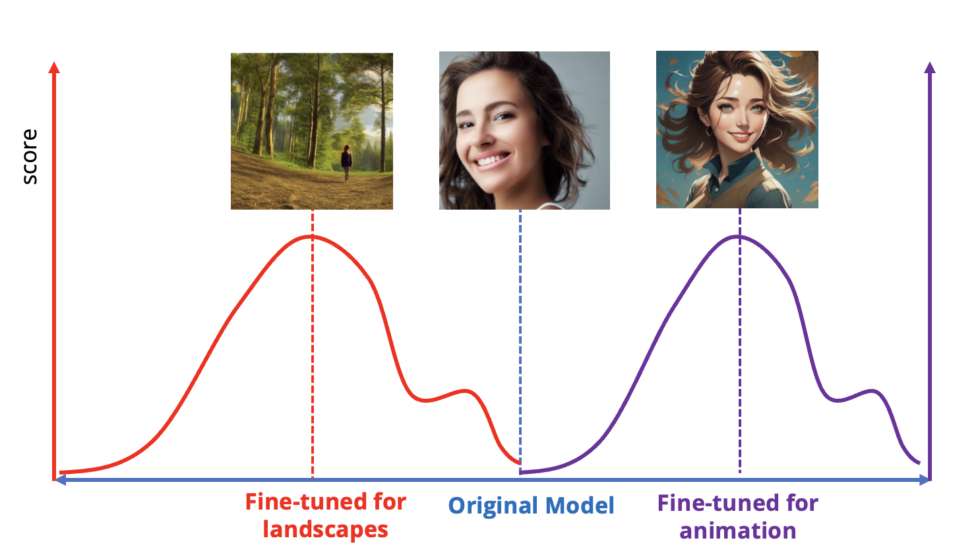

同样的事情也适用于人工智能。我们使用一种称为“梯度下降”的技术训练LLM的神经网络。梯度下降查看模型正在生成的输出,将其与训练数据进行比较,然后计算一个“方向”来调整神经网络的参数,使输出变得“更”正确,也就是说,看起来更像AI给出的训练数据。在我们的魔术自动完成的情况下,更正确的答案意味着输出文本更有可能跟随输入。

概率数学是计算机处理单词的好方法;计算一些单词跟随其他单词的可能性只是在计算,对于计算机来说,“多少”比“更正确或更错误”更容易使用。生成输出,与训练数据进行比较,然后进行调整。冲洗并重复,进行许多小的渐进式改进,最终你会把一个吐出胡言乱语的神经网络变成产生连贯句子的东西。这种技术也可以适用于图片、DNA序列等。